স্ক্র্যাপি মাকড়সা

স্ক্র্যাপি স্পাইডার হল এমন একটি শ্রেণী যা ওয়েবসাইটের লিঙ্কগুলি অনুসরণ করার এবং ওয়েবপৃষ্ঠাগুলি থেকে তথ্য বের করার সুবিধা প্রদান করে৷

এটি হল প্রধান শ্রেণী যেখান থেকে অন্যান্য মাকড়সা অবশ্যই উত্তরাধিকার সূত্রে পাবেন।

স্ক্র্যাপিংহাব

স্ক্র্যাপিংহাব হল স্ক্র্যাপি স্পাইডার চালানোর জন্য একটি ওপেন সোর্স অ্যাপ্লিকেশন। স্ক্র্যাপিংহাব ওয়েব সামগ্রীকে কিছু দরকারী ডেটা বা তথ্যে পরিণত করে। এটি আমাদেরকে ওয়েবপেজ থেকে ডাটা বের করতে দেয়, এমনকি জটিল ওয়েবপেজগুলির জন্যও৷

৷আমরা ক্লাউডে স্ক্র্যাপি মাকড়সা স্থাপন করতে এবং এটি কার্যকর করতে স্ক্র্যাপিংহাব ব্যবহার করতে যাচ্ছি।

স্ক্র্যাপিংহাব −

-এ মাকড়সা স্থাপনের পদক্ষেপধাপ1 −

একটি স্ক্র্যাপি প্রকল্প তৈরি করুন -

স্ক্র্যাপি ইনস্টল করার পরে, আপনার টার্মিনালে নিম্নলিখিত কমান্ডটি চালান -

$scrapy startproject <project_name>

আপনার ডিরেক্টরিকে আপনার নতুন প্রকল্পে পরিবর্তন করুন (project_name)।

ধাপ 2 −

আপনার টার্গেট ওয়েবসাইটের জন্য একটি স্ক্র্যাপি স্পাইডার লিখুন, আসুন একটি সাধারণ ওয়েবসাইট "quotes.toscrape.com" গ্রহণ করি।

নীচে আমার খুব সাধারণ স্ক্র্যাপি স্পাইডার -

কোড -

#import scrapy library

import scrapy

class AllSpider(scrapy.Spider):

crawled = set()

#Spider name

name = 'all'

#starting url

start_urls = ['http://www.tutorialspoint.com/']

def __init__(self):

self.links = []

def parse(self, response):

self.links.append(response.url)

for href in response.css('a::attr(href)'):

yield response.follow(href, self.parse) ধাপ 3 -

আপনার স্পাইডার চালান এবং আপনার links.json ফাইলে আউটপুট সংরক্ষণ করুন −

উপরের কোডটি কার্যকর করার পরে, আপনি সমস্ত লিঙ্ক স্ক্র্যাপ করতে এবং links.json ফাইলের ভিতরে সংরক্ষণ করতে সক্ষম হবেন। এটি একটি দীর্ঘ প্রক্রিয়া নাও হতে পারে তবে এটিকে ক্রমাগতভাবে চব্বিশ ঘন্টা (24/7) চালানোর জন্য আমাদের এই মাকড়সাটিকে স্ক্র্যাপিংহাবে স্থাপন করতে হবে৷

ধাপ 4 −

স্ক্র্যাপিংহাবে অ্যাকাউন্ট তৈরি করা হচ্ছে

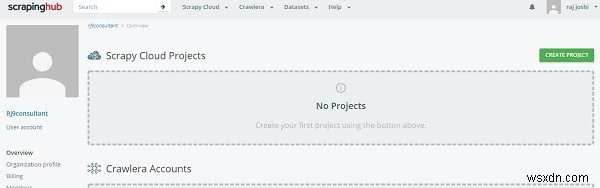

এর জন্য, আপনাকে শুধু আপনার Gmail অ্যাকাউন্ট বা Github ব্যবহার করে ScrapingHub লগইন পৃষ্ঠায় লগইন করতে হবে। এটি ড্যাশবোর্ডে পুনঃনির্দেশিত হবে৷

৷

এখন Create project এ ক্লিক করুন এবং প্রজেক্টের নাম উল্লেখ করুন। এখন আমরা কমান্ড লাইন (সিএলআই) ব্যবহার করে বা গিথুবের মাধ্যমে আমাদের প্রকল্পটি ক্লাউডে যুক্ত করতে পারি। এরপর আমরা shub CLI এর মাধ্যমে আমাদের কোড স্থাপন করতে যাচ্ছি, প্রথমে shub ইনস্টল করুন

$pip install shub

shub ইনস্টল করার পরে, অ্যাকাউন্ট তৈরি করার সময় তৈরি করা api কী ব্যবহার করে shub অ্যাকাউন্টে লগইন করুন (https://app.scrapinghub.com/account/apikey থেকে আপনার API কী লিখুন)।

$shub login

আপনার API কী ঠিক থাকলে, আপনি এখন লগ ইন করেছেন। এখন আমাদের ডিপ্লয় আইডি ব্যবহার করে এটি স্থাপন করতে হবে, যা আপনি "আপনার কোড স্থাপন করুন" বিভাগের কমান্ড লাইন বিভাগে দেখতে পাচ্ছেন (6 সংখ্যার নম্বর)।

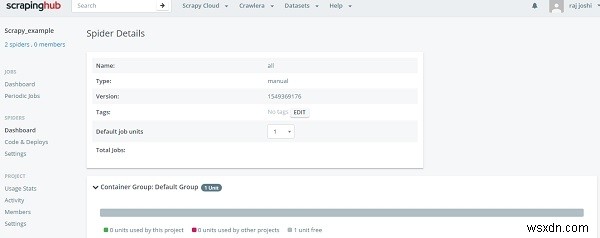

$ shub deploy deploy_id

এটি কমান্ড লাইন থেকে, এখন স্পাইডার্স ড্যাশবোর্ড বিভাগে ফিরে যান, ব্যবহারকারী প্রস্তুত মাকড়সা দেখতে পারেন। শুধু মাকড়সার নাম এবং রান বোতামে ক্লিক করুন৷এটাই এখন আপনি আপনার ড্যাশবোর্ডে আপনার মাকড়সা দেখতে পাবেন, যেমন −

এটি আমাদের দেখাবে, একটি ক্লিকের মাধ্যমে চলমান অগ্রগতি এবং আপনাকে আপনার স্থানীয় মেশিন 24/7 চালানোর প্রয়োজন নেই৷